macOS 安装软件打开显示 “已损坏,无法打开。 你应该将它移到废纸篓。

这种情况一般是作者没有订阅苹果的开发者服务,导致没有签名,不在果子的认证范围内,所以提示已损坏,无法打开。

解决办法就是手动认证一下。

当然前提是你必须要确认这个软件来源靠谱,如果你不知道这是啥软件,来源也比较可疑,建议不要操作。

下面是解决办法。

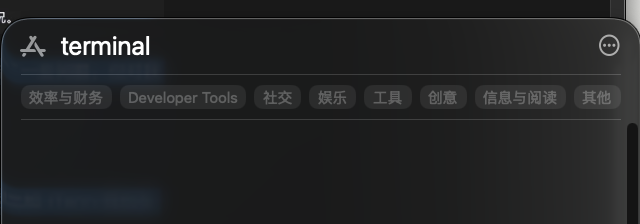

- 首先找到软件包的地址,然后组装成实际的地址,我这里以 ChatGPT.app 举例,实际的地址就是:

/Applications/ChatGPT.app- 执行下面的命令(替换你的软件包地址)

sudo xattr -dr com.apple.quarantine /Applications/你的软件包地址.app然后按提示输入密码即可。

软件就可以打开了。