如何使用 Google Gemini 作为 Xcode 的智能编程助手?

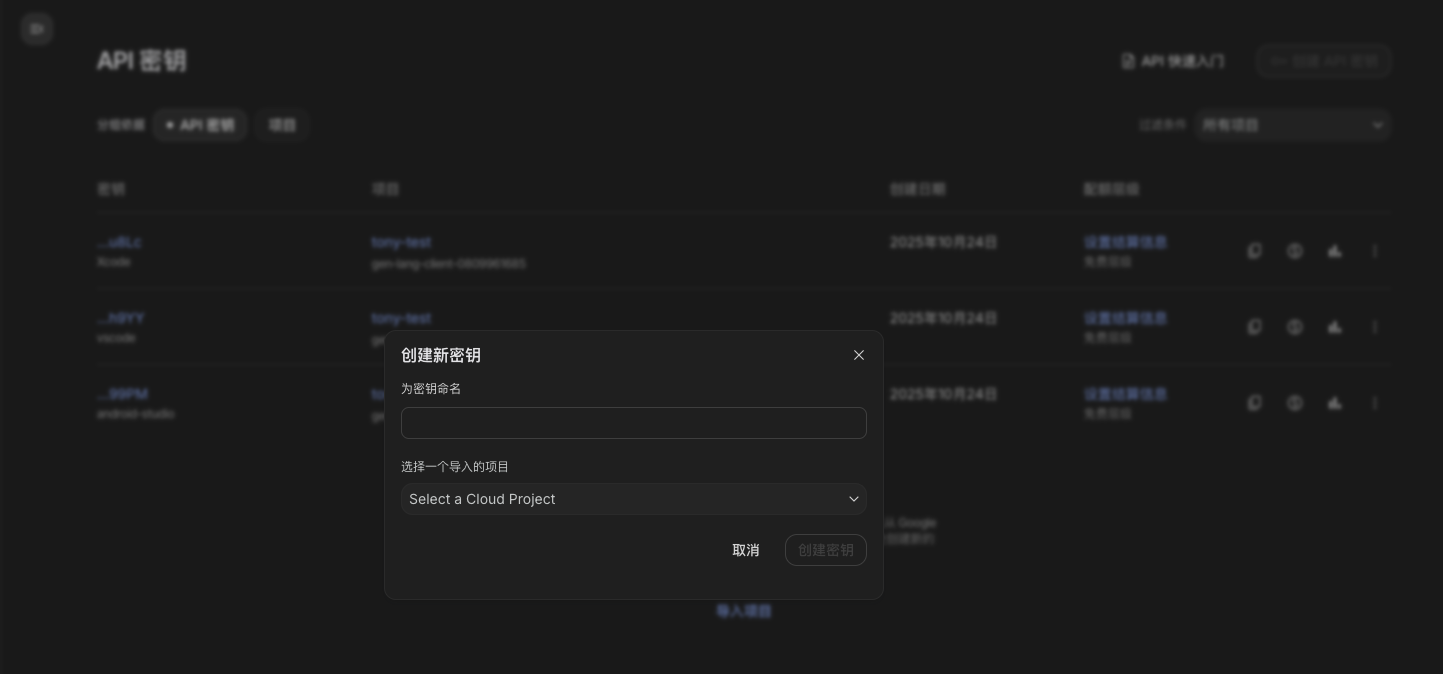

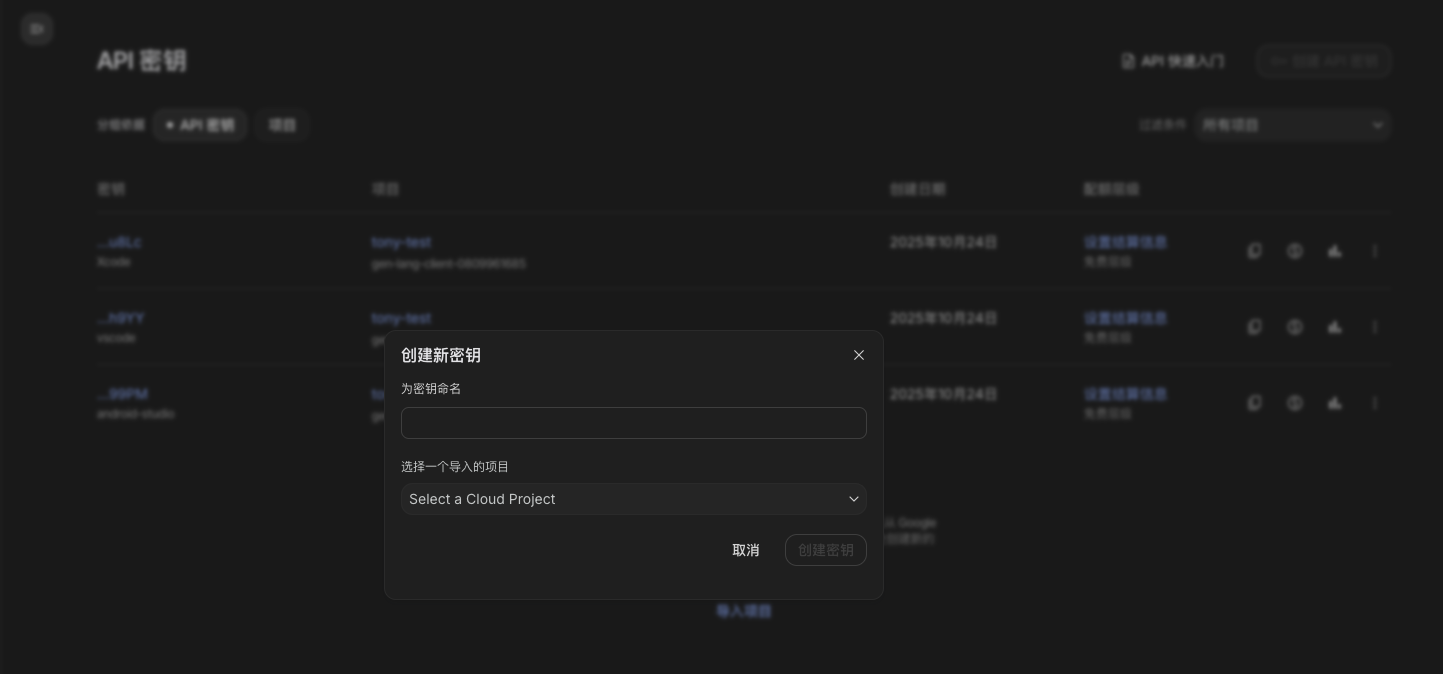

首先准备好 Gemini 的 API Key,可以在 这里 申请。

申请过程很简单,不赘述。

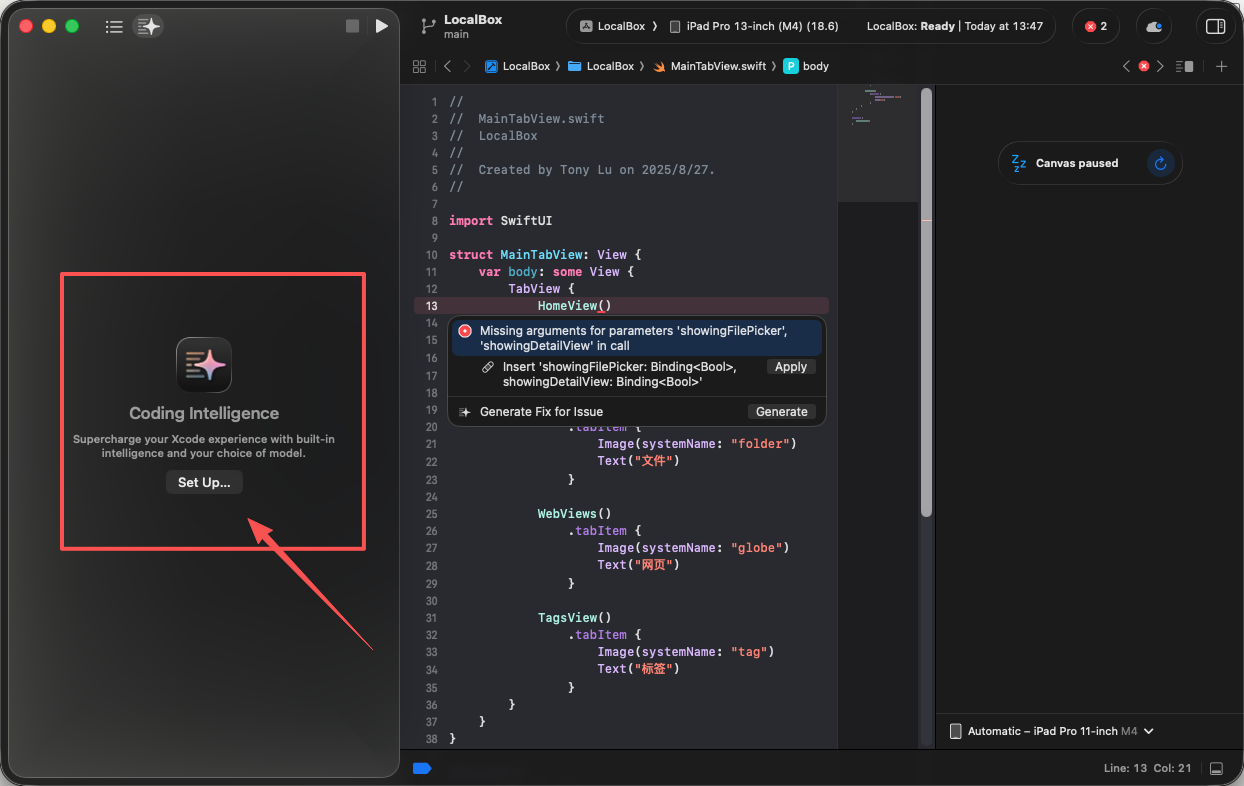

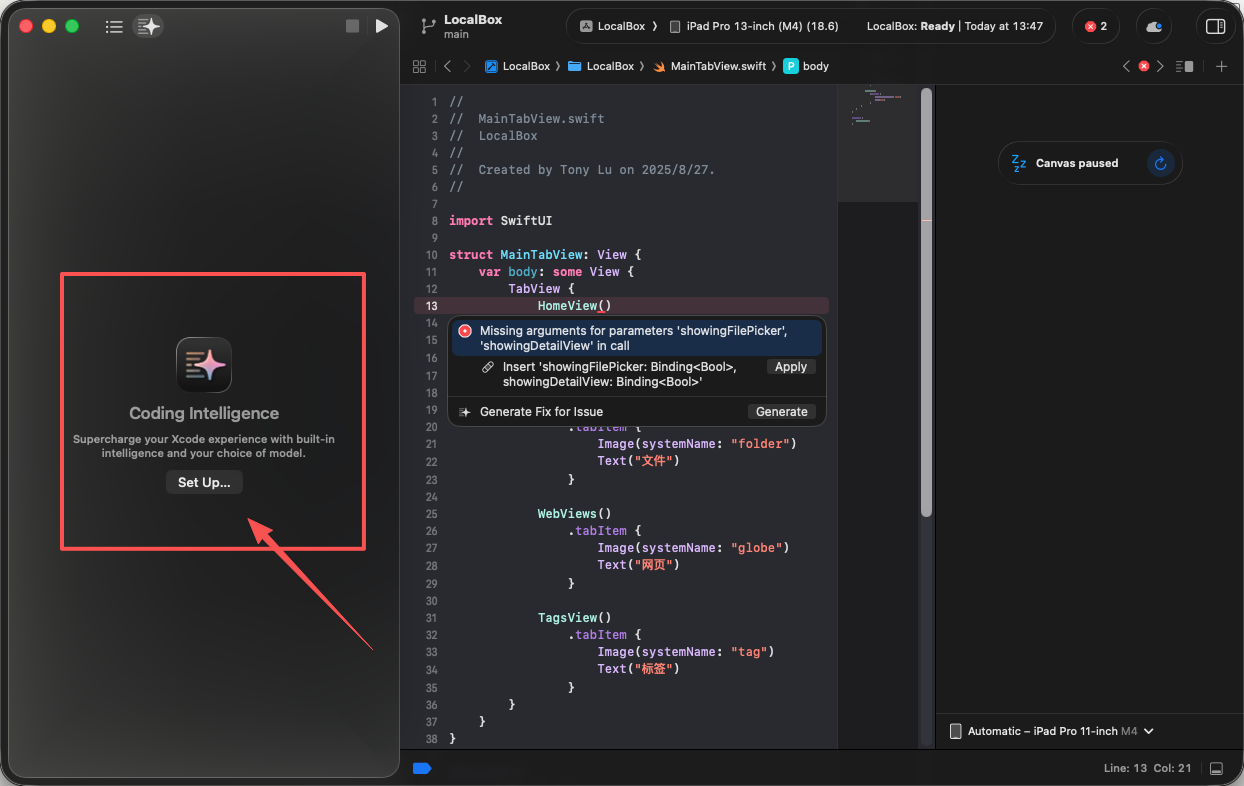

将 macOS 升级到最新的 26.0.1 版本,Xcode 也一样升级到最新版,然后就可以开始了。

第一步,点击这里的 "Set Up..." 按钮:

首先准备好 Gemini 的 API Key,可以在 这里 申请。

申请过程很简单,不赘述。

将 macOS 升级到最新的 26.0.1 版本,Xcode 也一样升级到最新版,然后就可以开始了。

第一步,点击这里的 "Set Up..." 按钮:

自从 Claude Sonnet 4.5 上线以来,好评如潮。很多 AI 编程助手都整合了 Claude Sonnet 4.5 模型,比如 GitHub Copilot。

不过 GitHub Copilot Pro 会员每个月只有 300 个 Premium Requests,一个月 30天,平均每天就 10 个请求,对于广大程序员来说,根本不够用,怎么办?

下面我要讲5个小技巧来优化你的 Vibe Coding 流程,让每一次 Premium request都用到点上。

之前那篇文章中我聊过这个问题,提的问题不要太大也不要太小。太大了超出 Tokens限制反而不好,太小了就是严重的浪费。

大问题拆解成几个模块分别提交。多个小问题可以聚合起来一起提交。

控制好颗粒度很关键,这个需要实战演练,自己把握。

Claude Sonnet 的上下文理解能力极强,但也意味着它在面对含糊问题时会尝试“猜你的意思”,从而浪费一次 premium 请求。

正确做法是:先用普通模型(如 Claude Instant 或 GPT-3.5)帮你把问题框清楚,比如确定 API 调用的结构、接口参数、上下文依赖,然后再让 Sonnet 出手解决关键逻辑或生成高质量代码。

用轻模型暖场,用重模型收割。

Vibe Coding 这个词最近很火。

这个词原本的含义是“凭感觉写代码”或“以氛围驱动的编程”。听起来有点抽象,其实背后是一种趋势:让开发过程更自然、更即时、更具创造性。

在 AI 辅助开发兴起的时代,“Vibe Coding”常指:开发者不再精确地计划每个函数和架构,而是与 AI 一起边想边写,让代码流动起来

但随着 A1 越来越智能,尤其是 Claude Sonnet 4.5 的横空出世,“Vibe Coding”更常用的含义变成了:我来指挥 A1写代码,顺便监工。

没错,我现在就是这个状态,

如果项目结构比较规范、需求比较明确的话,基本上不需要我手动编码,只需要提需求就行了,基本上就像个指挥程序员干活的产品经理。

当你升级了 ChatGPT 会员,准备开心得用上 Codex 时,坑来了。

在 VS Code 的插件库中搜索 Codex,你会看到 4 个 Codex——

其中,除了第一个是 OpenAI 出品外,其他 3 个都是不相关的。

我第一反应是有人山寨,但仔细看了一下发现都不是。

过去两年,AI 产品的形态经历了一次悄无声息但深刻的转变。最初,人们把 ChatGPT 当成一个“万事通”的聊天窗口,各种外部 App 都在想办法“嵌入 Chat”。从最早的 ChatGPT 插件到后来的 Actions,每个 App 都希望被 ChatGPT 调用,希望在那一行对话背后,能让模型触发自己的服务。这种形态其实沿袭了传统互联网思维:AI 是一个超级入口,而所有第三方都是被调用的 API,它们被动等待用户的自然语言指令,然后在后台完成任务。这一时期的 Chat,更像一个智能中控台,App 只是工具箱里的螺丝刀。

但今年情况变了。OpenAI 推出了 Apps SDK,一切开始反转。过去是 App 嵌入 Chat,现在是 Chat 嵌入 App。这听起来只是语序的变化,实则是产品范式的质变。Apps SDK 让开发者可以构建自己的 MCP 服务端(Model Context Protocol Server),再配上前端 widget,小到一个查询组件,大到一个完整的操作界面,都能被模型直接加载到对话中。与此同时,App 自身也能反向调用 ChatGPT,让聊天成为自己应用内部的一部分。这意味着 ChatGPT 不再是一个独立入口,而开始“渗入”每一个 App 的界面、逻辑与体验之中。

Nano Banana 是 Google 在其 Gemini 产品中引入的最新图像编辑与生成模型,官方名称为 Gemini 2.5 Flash Image。它不仅具备强大的图像生成能力,还能通过自然语言精准编辑已有图像,在 Image 编辑模型排行榜 LMArena 上排名首位,广受好评。

前几天在社区就火起来一个生成桌面角色模型的提示词:

将这个角色转换为一个角色模型。在它后面放置一个印有该角色图像的盒子,并且让一台电脑屏幕上显示Blender建模过程。在盒子前面添加一个圆形塑料底座,让角色模型站在上面。如果可能的话,请将场景设置在室内。

我亲自测试了一下,效果确实不错:

本来以为只是国内程序员圈子里的吐槽,没想到字节跳动这款 AI 编程工具 Trae,最近还引起了海外科技媒体的注意。

7 月 29 日,日本知名科技媒体 Gigazine 发布了一篇长文,披露了一位开发者对 Trae 的实测结果,核心问题就一个:即便关闭了遥测功能,Trae 依然在上传数据。

Trae IDE 作为 AI 编辑器,正试图在越来越受欢迎的 Cursor 市场中分一杯羹。它可以接入 OpenAI 的 GPT 系列、Anthropic 的 Claude 等大模型服务。

关于 Trae IDE,有用户报告称其“进程数过多”。下面的图片是将 Trae IDE、VSCode、Cursor 的进程数和内存使用量分别对比的结果。可以看出,相比于 VSCode(进程数 9、内存 0.9GB)和 Cursor(进程数 11、内存最高 1.9GB),Trae IDE 的进程数达到 33 个,内存使用也达到了惊人的 5.7GB,是 VSCode 的 5 倍以上。

上周末看到 Coze 开源的消息,本来有点小兴奋,但等我了解了其中的细节后,还是有点失望的。

首先简单介绍一下 Coze(扣子)。

Coze 中文名扣子,是字节跳动(ByteDance)旗下推出的一款 AI Agent 创建与管理平台,主要面向开发者和普通用户,允许用户像搭积木一样构建自己的智能体(AI Agent),并通过简单的配置实现多轮对话、API 调用、知识库问答等功能。

简单理解,Coze 就像是一个“ChatGPT 的拼装工厂”,你可以把多个模块(比如知识库、插件、函数调用等)组合起来,让一个 AI 聊天机器人具备特定能力,并部署到多个平台(如微信公众号、飞书、网页等)。

不过以上说的是非开源版本,实际这次开源的版本阉割了很多东西,这个后面细讲。

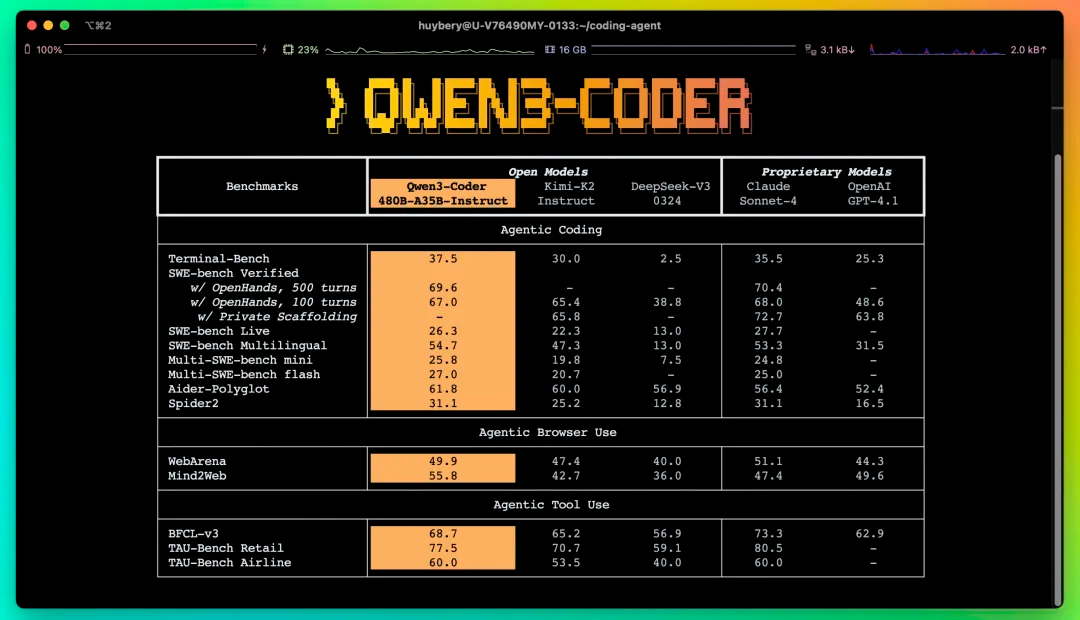

阿里昨天发布的代码模型 Qwen3-Coder,有 4800 亿参数,是阿里迄今为止最具代码推理能力的代码模型,官方宣称“可以与 Cluade Sonnet4 媲美”。

下面是官方宣称的一些关键信息:

还好是阿里发布的,这要是菊花发布的,大嘴高低得喊俩小时的遥遥领先。

我在社区看到很多人体验后说效果确实很不错,编码能力确实出众。我本来也想试试,但在看到很多网友吐槽费用后,果断放弃了:

谷歌刚刚发布了 Gemini CLI,据说对标 Claude Code 和 Cursor。

不仅免费,而且开源(已经 24.8k Star了),真乃业界良心。

本地安装环境仅需要 Node.js 高于 18 版本,然后执行 npm 命令安装即可。

npm install -g @google/gemini-cli首次登录到浏览器登录谷歌账号验证一下,需要注意的是你的终端里记得挂代理。

我用我的号试了一下,可以使用,虽然谷歌知道我的这个号中国的,挂了代理还是可以用的。

免费的额度是每分钟 60 次模型请求,每天 1000 次请求。

我一开始问了个简单的问题试了一下,只是为了看看能不能用: